دیپ فیک (DeepFake) یک فناوری جدید در حوزه هوش مصنوعی است که این بار در سوژه قدیمی «سلامتی رهبر معظم انقلاب» به کار گرفته شده است.

به گزارش فراق، فناوری هوش مصنوعی مرزهای تکنولوژی و فناوری را در حوزه «جعل» نیز بسیار جلوتر برده و اگر در گذشته تنها ممکن بود یک عکس توسط نرم افزارهای گرافیکی دستکاری شده و چیزی خلاف واقعیت (به قول معروف فتوشاپی) به بیننده نشان دهد، امروز با فناوری خطرناکتری روبه رو هستیم که میتواند چهره و صدای افراد را به طرز شگفتآوری تقلید کرده و در قالب ویدیوهای غیر واقعی منتشر کند.

فناوری دیپ فیک بر مبنای هوش مصنوعی است که به واسطه آن تصاویر و ویدیوهای دروغین، اما «واقعینما» درست میشود و میتواند هر بینندهای را تحت تاثیر خود قرار دهد. امروزه ویدیوهای دیپ فیک بسیاری از هنرمندان و افراد مشهور ساخته میشود و بیننده بدون آنکه متوجه عدم صحت و واقعیت آنها شود، محتوای آنها را باور کرده و به انتشار آنها در فضای مجازی دست میزند.

در حالی که طی سالهای اخیر، برای پرهیز از فریب خوردن با محتواهای جعلی بر سواد رسانهای و توجه به «سند» و «فکت» تاکید شده، با پیشروی بدون محدودیت این فناوری، درواقع سندها و فکتهای جعلی تولید شده و از آنجا که تشخیص بین مرز حقیقت و دروغ گاه کاملا غیر ممکن میشود، بسیار خطرناک است.

دیپ فیک یا فناوری «جعل عمیق» چیست؟

فناوری دیپ فیک یا «جعل عمیق» سال ۲۰۱۴ برای اولین بار توسط یک دانشجوی مقطع دکترا به نام «ایان گودفلو» اختراع شد. دیپ فیک از ترکیب دو واژه Deep به معنای عمیق و Fake به معنای جعلی و دروغین تشکیل شده و براساس هوش مصنوعی قادر است تصاویر انسان را به صورت واقع نمایانه تولید کند. در این فناوری، با استفاده از الگوریتمهای یادگیری ماشین، تصاویر، صدا و ویدیوهای موجود از شخص تحلیل، و محتوا و فیلم یا صدای ساختگی بر آنها بار میشود.

در این سیستم وظیفه یکی از مدلها تولید محتوا (تولید تصاویر افراد) و وظیفه مدل رقیب، تشخیص واقعی بودن و یا جعلی بودن عکس تولید شده است. البته در ابتدای کار مدل هوش مصنوعی رقیب قادر است به راحتی عکس و محتوای جعلی را از واقعی تشخیص دهد؛ اما با گذشت زمان، دقت و عملکرد مدل هوش مصنوعی تولیدکننده به قدری افزایش مییابد که تشخیص جعلی بودن محتوای تولیدشده برای مدل رقیب بسیار سخت میشود.

چرا فناوری دیپ فیک خطرناک است؟

فناوری جعل عمیق، نه تنها بازیگران و سلبریتیها را هدف گرفته، بلکه به حریم چهرههای بزرگ سیاستمدار نیز تجاوز کرده است. به عنوان مثال ویدیویی از باراک اوباما منتشر شد که در آن دونالد ترامپ را فردی حقیر و غیرمنطقی خطاب میکرد. اگرچه این ویدیو صحت نداشت و کاملا غیرواقعی بود، اما افراد زیادی آن را باور کردند و دست به انتشار آن در فضای مجازی زدند. اوباما هم در خصوص تکنولوژی دیپ فیک گفته: در دنیایی که میتوانند به سادگی صحبتها و ویدیوهای غیرواقعی از من ساخته و منتشر کنند، به مرحلهای خواهیم رسید که تشخیص مرز بین واقعیت و دروغ بسیار مشکل خواهدشد و این مطمئنا بر پایههای دموکراسی ما که بر مبنای حقیقت است، تاثیر خواهد گذاشت.

با این فناوری، افراد با اهداف خصمانه میتوانند فیلمهای غیراخلاقی از چهرههای مشهور تهیه و تولید کنند و زندگی شخصی آنها را به راحتی به خطر بیندازند یا دموکراسی و امنیت ملی یک کشور را نیز به خطر اندازند.

نرم افزار دیپ فیک Zao که ویدیوی جعلی می ساخت

اپلیکیشن چینی Zao که قبلا یکی از پرسروصداترین اپها شناخته میشد، قادر است در کسری از ثانیه با دریافت چند عکس از کاربر، چهره او را به سلبریتی موردعلاقهاش تبدیل کند. اما پس از چندی کاربران بسیاری به سرعت موجی از نارضایتی خود را در خصوص نقض حریم خصوصی خود اعلام کردند و حال این نرم افزار، سیاستهای خود را بعد از واکنش جدی و بازخوردهایی که از سوی کاربران دریافت کرده، تغییر داده است.

در حال حاضر برنامههای متنوعی نظیر Zao موجود است که با تکنیک هوش مصنوعی و دیپ فیک، چهره کاربر را تغییر میدهند و بیشتر جنبه فان و سرگرمی دارند، اما با توجه به گزارشهای متعدد در مورد نقض حریم شخصی کاربران، باید قبل از استفاده از این نوع اپلیکیشنها، قوانین هر کدام را با دقت مطالعه کرد. اما مهم این است که با گسترش فناوری دیپ فیک، در آیندهای نه چندان دور عملا تشخیص بین مرز حقیقت و دروغ غیرممکن خواهد شد.

روش ترکیبی برای شایعهسازی درباره رهبر انقلاب

در روزهای اخیر، این روش در کنار روشهای دیگر در کنار هم، برای تولید شایعه درخصوص رهبر انقلاب به کار رفته است.

چندی پیش (۱۴ خرداد) کانالی با عنوان «خبررسان شبکه یک»، خبری با این عنوان منتشرکرد: «انتقاد دکتر شاهین محمدصادقی به آیتالله گلپایگانی رئیس دفتر مقام معظم رهبری/ چرا جلوی شرکت حضرت آقا در مراسم امروز را نگرفتید؟ سلامت ایشان اوجب واجبات است»

در این خبر به نقل از آنچه «گفتگوی دکتر شاهین محمدصادقی، جراح فوق متخصص و نماینده ادوار مجلس در گفتگو با شبکه خبر صدا و سیما» بیان شده، «احتمال عود بیماری که رهبری برای آن جراحی کردند»، وجود «علائم التهاب» و «استرسزا» بودن دیدارهای رهبر انقلاب، از زبان او مطرح و نام یک دارو و یکی دو لغت علمی هم برای باورپذیر بودن موضوع چاشنی خبر میشود.

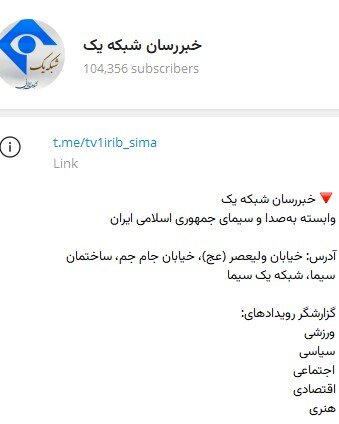

نکته مهم در این زمینه، منبع این شایعه است: کانالی با آرم شبکه اول سیما که نام آن هم «خبررسان شبکه یک» است و در توضیح، خود را «وابسته بهصدا و سیمای جمهوری اسلامی ایران» و آدرس خود را هم نشانی صداوسیما داده است.

این کانال توسط فعالان سایبری آلبانی هدایت میشود، اما در انتخاب اخبار و ادبیات به کار رفته، تلاش دارد شباهت به ادبیات رسمی صداوسیما در آن دیده شود تا باورپذیر باشد. این در حالی است که اساسا چنین مصاحبه ای انجام نشده است.

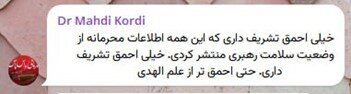

نکته دیگر، انتشار اخبار تکمیلی بعد از این مطلب است که تلاش دارند باورپذیری شایعه اولیه را افزایش دهند: ابتدا یک پیام مجازی که ساختن آن برای هر کسی در یک دقیقه امکان پذیر است؛ با این محور: «واکنش تند دکتر مهدی کردی، به اظهارات شب گذشته دکتر شاهین محمدصادقی درباره وضعیت سلامتی رهبری» منتشر میشود. البته معلوم نیست این دکتر کردی کیست، چه سمتی دارد و این نقد خود را کجا بیان کرده است؟

در گام بعدی، نامه ای به رئیس صداوسیما نسبت داده می شود که «بابت سخنان محمدصادقی در شبکه خبر» از او انتقاد کرده است تا برای مخاطب، اصل شایعه اولیه (سخنان محمدصادقی) هم تثبیت و هم تکرار شود. این خبر البته از آنجا که نامه ای را به جبلی، رئیس صداوسیما نسبت داده بود، با تکذیب روابط عمومی این سازمان (https://www.jamejamdaily.ir/Newspaper/item/234808) همراه شد:

جعل عمیق درباره سلامتی رهبر انقلاب

۲۰ فروردین سال ۱۴۰۳، دکتر علیرضا مرندی، رئیس فرهنگستان علوم پزشکی و پزشک رهبر انقلاب در برنامه برمودای شبکه نسیم با اجرای کامران نجف زاده حضور یافت و مطالبی درباره سلامتی رهبر معظم انقلاب هم گفت.

۱۱ ژوئن/ ۲۲ خرداد همین کانال فایلی صوتی، منتشر کرده که حاوی جعل عمیق است و بعدا در شبکه تیک تاک (https://www.tiktok.com/@yek_rangi1/video/7379930302950477088)، یوتیوب و توییتر هم بازنشر میشود.

در این فایل صوتی که روی تصویری جعلی از صفحه اینستاگرام کامران نجف زاده قرار داده شده، با همین فناوری deep fake صدای مرندی و نجف زاده بازسازی شده است.

در این فایل صوتی، با صدای دکتر مرندی بیان میشود که «دادههای پزشکی سلامتی رهبری را تا زمستان امسال تضمین میکند و پس از آن نیز انشاءالله دعای مردم شفابخش خواهد شد.» این به خواننده القا میکند که آیتالله خامنهای از بیماری جدی رنج میبرند.

در این فایل ساخته شده، سخنان نجف زاده و مرندی بریده بریده بیان می شود که حاصل فایل هوش مصنوعی به کار گرفته شده است. همچنین جملاتی نظیر این که تا یک زمان مشخص به بیمار تضمین داده شده و از زمانی به بعد اعلام نگرانی شود، کمتر از سوی یک پزشک بیان میگردد.

کسانی که صدای دکتر مرندی را شنیدهاند، به راحتی تمایز تن صدای او را با این صدای ساخته شده تشخیص میدهند؛ هرچند این تشخیص برای همه افراد میسر نیست.

اما در این موضوع نیز در کنار ساخت این فایل صوتی، از شایعات تکمیلی برای جا انداختن شایعه اولیه بهره گرفته میشود.

مثلا ادعا شده: «مجری برنامه برمودا چند ساعت بعد این پست را بهدستور آقای وحید جلیلی، قائم مقام رئیس صدا و سیما حذف کرد … گفته میشود آقای علی خرم، نجفزاده را مکلف کرده فایل صوتی را که منتشر کرده، تکذیب و آن را شایعه بنامد. گویا نجفزاده شرط گذاشته در صورتی چنین اقدامی میکند که پروندهای برایش تشکیل نشود.» حتی اندکی بعد شایعه «تاییدنشده» بازداشت مجری برنامه برمودا منتشر شد تا خبر جعلی اولیه باورپذیرتر شود.

فرهنگستان علوم پزشکی (https://www.hamshahrionline.ir/news/860684) هم بعد از این شایعات اعلام کرد: اخیراً فایلی ساختگی از گفتوگوی تلفنی مجری برنامه برمودا با دکتر سیدعلیرضا مرندی منتشر شده که جعلی است.

سابقه شایعه درباره سلامتی رهبر انقلاب

شایعهسازی درباره سلامتی رهبر انقلاب محدود به این موارد نیست و دو سال قبل (۲۳ شهریور ۱۴۰۱/ ۱۴ سپتامبر) هم روزنامه آمریکایی نیویورک تایمز در گزارشی (https://www.radiofarda.com/a/new-york-times-khamenei/32037897.html) به نقل از منابع مطلع مدعی جراحی و بیماری ایشان و قطع تمام برنامه ها شد، اما ۳ روز بعد رهبر انقلاب در مراسم دانشجویی اربعین (https://farsi.khamenei.ir/speech-content?id=50944)شرکت کردند.

البته فهم علت توجه چندین باره به این سوژه تکراری، چندان دشوار نیست؛ با این حال آنچه جامعه را در برابر اخبار جعلی پیشرفته عصر هوش مصنوعی مصون میکند، دقت، آگاهی دادن و رشد اعتماد عمومی است.

انتهای پیام